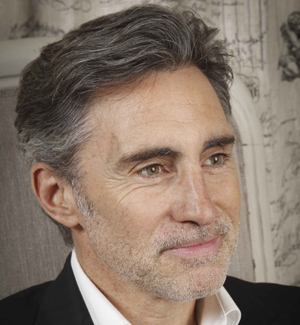

Régis Castagné (Interoute) : « Big Data et Cloud Computing sont intimement liés »

Avis d’expert : Directeur d’Interoute, Régis Castagné, revient pour nous sur le lien étroit entre Big Data et Cloud Computing.

Nous assistons à une explosion de la production d’information, les mobinautes générant du contenu en temps réel, avec les appareils photo de leurs téléphones et leur accès Internet. Tous ces contenus, ajoutés aux données générées au fil des ans, constituent ce qu’on appelle le Big Data, un amoncellement de données qu’il devient difficile de stocker et d’analyser.

Wikipedia précise que, selon une étude IDC sponsorisée par EMC (1), les données numériques créées dans le monde seraient passées de 1,2 zettaoctets par an en 2010 à 1,8 zettaoctets en 2011, puis 2,8 zettaoctets en 2012, et s’élèveront à 40 zettaoctets en 2020. Twitter générait, début 2013, 7 teraoctets de données chaque jour et Facebook 10 teraoctets (2).

Le Gartner prévoit que les particuliers hébergeront 36% de leurs données dans le cloud d’ici 2016, alors que le taux était de 7% en 2011. La pénurie de disques durs due aux inondations en Thaïlande aurait accéléré la tendance à l’hébergement dans le cloud au premier semestre 2012, selon le cabinet d’études qui annonce que le contenu individuel stocké en ligne devrait passer de 464 Go en 2011 à 3,3 To en 2016 (3).

Le secteur produisant le plus de données est sans commune mesure le domaine scientifique. En témoignent les projets Big Data autour de la découverte du Boson de Higgs (4) ou les travaux de l’Agence Spatiale Européenne pour développer une plateforme d’exploitation des données concernant les grands sites à risque géologique (5).

Stockage, données et réseaux

Pour nous, propriétaires des infrastructures et des réseaux, il s’agit de gérer la quantité de données que nous devons stocker, à un rythme qui s’accélère, et nous sommes défiés sur notre rapidité à stocker, à traiter, et à faire circuler les informations aussi diverses soient-elles (photos, vidéos, documents, etc.) entre les data centres.

Le stockage et la génération de contenu ne coûtent pas cher de nos jours et nous avons tendance à ne rien vouloir supprimer, ce qui nécessite d’avoir une bonne capacité d’analyse de l’ensemble des données stockées dans le cloud pour donner son utilité à chacune. Concrètement, un grand ‘cluster’ est construit pour traiter l’information, et sa taille change aussi rapidement qu’il est généré. Il faut donc une grande capacité de calcul pour l’analyser, et seule la répartition dans plusieurs data centres pour des calculs parallèles le permet, d’où l’importance du Cloud Computing.

L’arrivée du cloud, qui baisse le coût du stockage, a créé une plateforme sur laquelle on peut contrôler le prix de base et créer un équivalent moderne du Grid Computing.

Une analyse qualifiée de grandes quantités de données réparties entre plusieurs sites doit être proposée à des tarifs accessibles, ce qui implique un accès à l’information à un coût raisonnable, un domaine dans lequel la virtualisation des data centres a son rôle à jouer.

Les fournisseurs d’infrastructure apportent leur pierre à l’édifice du Big Data en permettant notamment d’alléger les coûts. L’analyse qualifiée est ce qui donne son impulsion actuelle au Big Data et certains analystes affirment que le Big Data est ce qui stimulera l’économie dans le futur.

(1) Étude IDC-EMC « Extracting value from chaos » citée par Delphine Cuny sous le titre « « Big data » : la nouvelle révolution », Virginia Rometty, La tribune, nº 42, 29 mars au 4 avril 2013, p. 4

(2) https://www.cnrs.fr/fr/pdf/cim/28/#/1/ [archive]

(3) https://www.channelnews.fr/expertises/etudes/13031-le-stockage-dans-le-cloud-des-particuliers-devrait-quintupler-dici-2016.html

(4) https://www.b-consulting.com/Scientifiques-et-grandes

(5) https://www.b-consulting.com/L-Agence-Spatiale-Europeenne,2234

Voir aussi

Silicon.fr étend son site dédié à l’emploi IT

Silicon.fr en direct sur les smartphones et tablettes