Ce dossier est dédié aux diverses options qui s’offrent pour la modernisation ou la refonte de ‘Datacenters’. Il est constitué de 4 volets principaux

Introduction

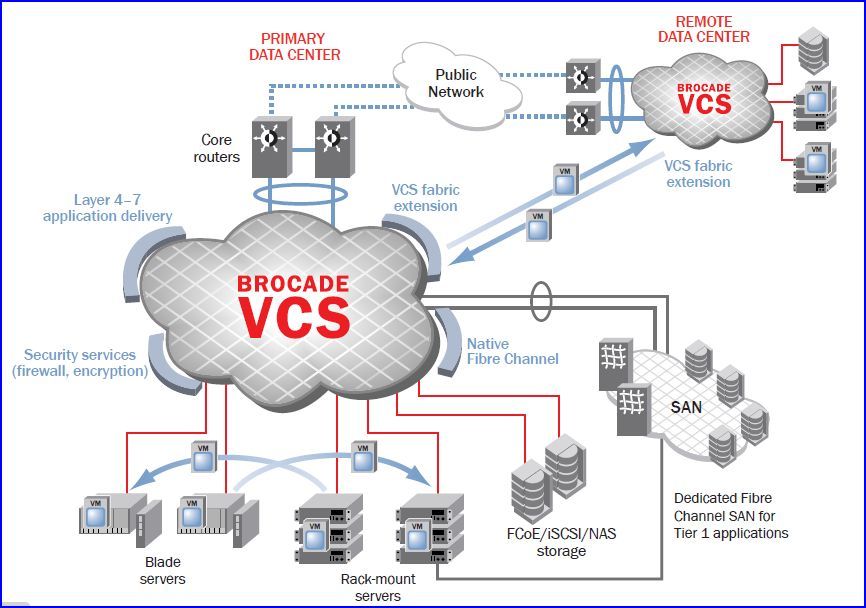

Dans le contexte de la modernisation de leur SI, la plupart des entreprises travaillent à une refonte de leur ‘datacenter’, voire à une consolidation: c’est à dire une reconfiguration de plusieurs sites de traitement vers un site principal (ou quelquefois deux) et vers un site de secours pour assurer un plan de continuité de service.

Ces mêmes entreprises cherchent également à optimiser les coûts de fonctionnement et d’administration ; elles veulent diminuer la facture énergétique. Surtout, elles se concentrent sur une simplification de leur infrastructure, et ce tout en recherchant plus de souplesse, plus d’agilité, afin de déployer rapidement de nouveaux services. Certaines envisagent déjà un modèle de prestations de services « à la demande » en configuration « cloud » privé, plus rarement en ‘cloud’ public.

Comme déjà évoqué, ces entreprises en profitent pour redéfinir ou parachever leur plan continuité d’activité, avec un deuxième voire un troisième centre de données pour la sauvegarde et la restauration de leurs données sur un site « miroir » distant.

Dans ce contexte, que peut apporter la convergence des réseaux de stockage et des serveurs d’applications virtualisées à l’intérieur du ‘datacenter’ ?

Quels sont les scénarios et les offres intéressantes du marché qui permettent d’organiser cette convergence?

1- La refonte du SI et du datacenter: enjeux et tendances

2- Les scénarios de rénovation ou de migration des datacenters

3- Choix d’urbanisation et retour sur investissement

4-ENTRETIEN: M. Klayko, Brocade: ‘Oui, nous sommes challengers de Cisco‘

Partie 1- La refonte du SI et du datacenter: les enjeux, les tendances

1.1- Les investissements prioritaires, selon les cabinets d’analystes

Les évolutions techniques impactent directement l’organisation des centres de données. Selon une étude Gartner publiée en janvier 2010, portant sur les dépenses IT des grandes entreprises du secteur public et privé, et ce dans le monde entier, les principaux postes de dépense devraient avoir un effet direct sur les centres de données. Arrivent en première place des dépenses la virtualisation, suivie du ‘cloud computing’, et du web 2.0.

De fait, l’impact de la virtualisation sur la gestion des serveurs physiques à l’intérieur du data center est majeur. Passant d’un niveau de charge de 20% à parfois 80%, les serveurs physiques exigent désormais des volumes d’alimentation et de refroidissement de plus en plus importants. La mise en place de ‘clouds‘ privés et publics exige un degré d’ouverture de plus en plus important pour permettre une allocation à la demande des ressources à distance. Enfin, l’intégration d’applications riches de type web 2.0 dans les centres de données provoque une multiplication des relations stockage serveur (ne serait-ce qu’en raison de l’utilisation de nouveaux langages de type flex).

Autant de mutations qu’il faut prendre en considération sous peine de courir le risque de posséder une infrastructure sous-dimensionnée par rapport aux exigences des utilisateurs d’une part, et des nouvelles technologies d’autre part.

1.2- La volumétrie des data :

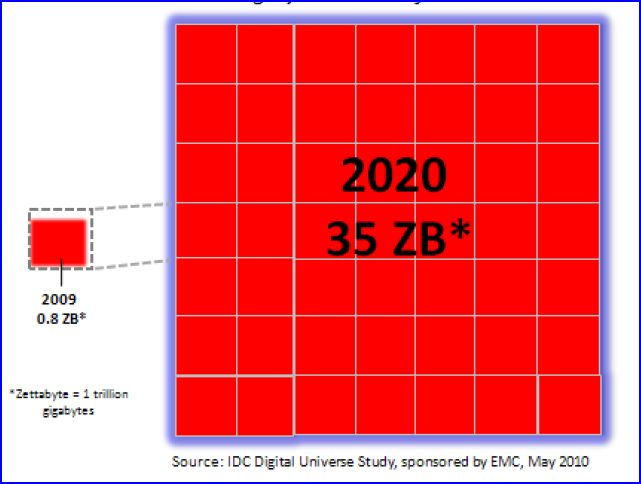

Multiplication des cœurs au sein même des processeurs, ponts de plus en plus fréquents entre différents clouds, reliés à la demande au centre de données principal, réplication des données vers un site distant, accroissement des connexions entre serveurs d’application et instances de stockage ; la volumétrie des centres de données est en forte croissance.

A titre d’exemple: dans le domaine de la santé, depuis 2004, le volume des données sauvegardées par le CHU de Rennes est passé de 20 à 360 To, soit une croissance multipliée par 3,3 tous les 18 mois ! Et cela ne concerne que le stockage !

–

L’expansion de l’univers digital

En 2009, malgré la récession mondiale, l' »univers digital » a atteint un seuil record. Il s’est accru de +62% à 800.000 péta-octets! (un péta-octets, c’est un million de Giga-octets). Copiés sur des DVD, cela constituerait une chaîne ininterrompue de la Terre à la Lune!

En 2010, l’univers digital aura grossi pour atteindre 1,2 millions de péta-octets, soit 1,2 zetta-octets.

A ce rythme, notre ‘univers digital’ sera 44 fois plus vaste que celui de 2009

.

–

–