Modèles text-to-video : avec qui voisine Sora ?

Google, Meta, Stability AI… Voici quelques initiatives de modèles text-to-video qui avaient émergé avant qu’OpenAI dévoile Sora.

Jusqu’à 60 secondes de vidéo à partir d’une invite textuelle ? Il y a Sora pour ça.

OpenAI a officialisé, la semaine passée, ce modèle text-to-video… qui a suscité un certain emballement, bien qu’au stade expérimental en cercle fermé.

Stable Diffusion décliné en version vidéo

Pour trouver un modèle de ce type ouvert à un plus large public, on peut se tourner vers l’API de Stability AI. Elle donne, depuis quelques semaines, accès à Stable Video Diffusion. Celui-ci ne prend toutefois pas de texte en entrée : c’est un modèle image-to-video.

Le prix est fixe : 20 $ pour créer une vidéo. Le modèle est entraîné pour générer 25 images, de 3 à 30 FPS, en 1024 x 576, 576 x 1024 ou 768 x 768. On nous annonce un temps de traitement « inférieur à 2 minutes ».

Stability avait officialisé le modèle en novembre 2023. Ou plus précisément les modèles. La version « 25 images » se base effectivement sur une version « 14 images ». Code d’inférence et poids sont disponibles pour un usage non commercial. Une UI web est dans les cartons.

Stable Video Diffusion est en alpha. L’API est récemment passée sur la version 1.1 du modèle. À la clé, davantage de garanties de reproductibilité, des paramètres supplémentaires pour monter en qualité et des progrès sur la génération aux formats carré/portrait.

Imagen et Lumiere, deux initiatives text-to-video origine Google

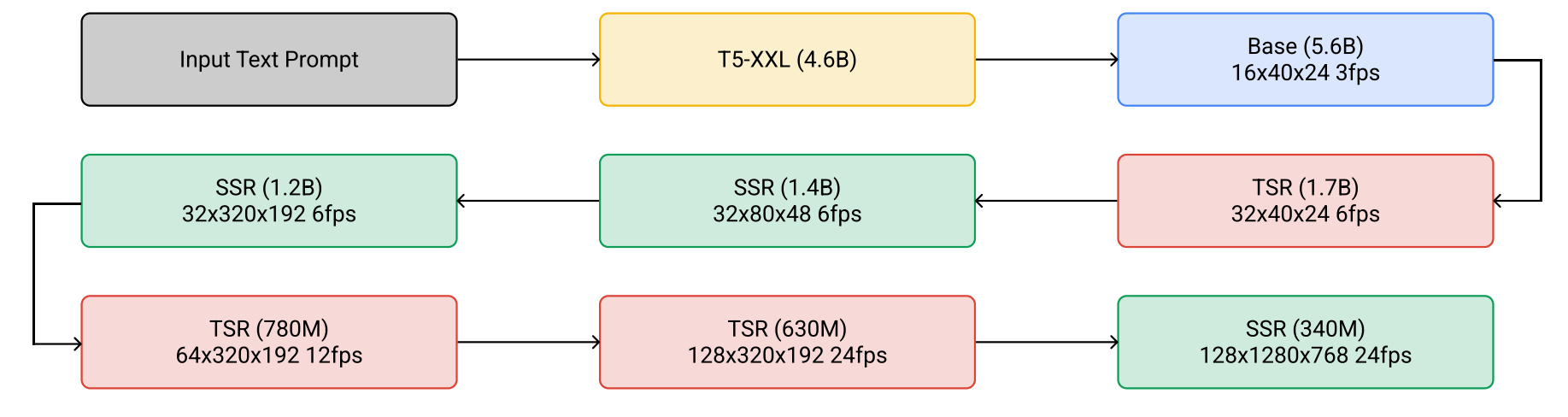

Chez Google, le modèle Imagen fait l’objet d’une exploitation commerciale pour ses capacités de génération d’images. Il peut aussi créer des vidéos, mais cette fonctionnalité reste à l’état de recherche. Elle a fait l’objet d’un article publié en 2022. On y entrevoit une architecture impliquant une « cascade » de modèles de diffusion spatiaux et temporels interlacés.

Google a un autre modèle text-to-video dans ses labos : Lumiere. Il a fait l’objet d’un article en janvier 2024. Ici, pas d’architecture en cascade, mais une approche unifiée : plutôt que de générer des images séparées et de combler le vide à renfort de modèles de super-résolution temporelle, on génère la vidéo en une passe.

Comme avec Stable Diffusion Video et Imagen, on reste sur des vidéos de quelques secondes, loin de ce que promet OpenAI.

Make-a-Video, expérimentation made in Meta

Meta a aussi fait étalage de travaux dans le domaine des modèles text-to-video. En particulier avec Make-a-Video. On y retrouve une approche fusionnant les couches spatiales et temporelles.

Make-a-Video a suivi un entraînement en deux temps. D’abord à partir de paires texte-image pour « apprendre à quoi ressemble le monde et comment on le décrit ». Puis de vidéos non annotées pour en « comprendre le mouvement ».

Le modèle peut travailler aussi bien à partir de texte que d’images. Il peut créer des variations d’une vidéo et créer un mouvement entre une image de départ et une image d’arrivée.

Illustration principale © Tada Images – Adobe Stock