Trois questions sur Grok, cet autre rival de ChatGPT

xAI a levé le voile sur Grok, son concurrent de ChatGPT. Aperçu en trois points.

Grok, entraîné en partie sur le dataset The Pile* ? Brian Roemmele n’en démord pas, en dépit du démenti que lui a opposé un employé de xAI.

Sur le papier, ce concurrent de ChatGPT a été formé à l’aide de données « issues d’Internet (jusqu’au troisième trimestre 2023) » et d’informations « fournies par des AI Tutors ».

Ces derniers, des « créateurs, enseignants et conservateurs [curators] […] excellents en rédaction et experts dans leur domaine », travaillent à distance pour apporter une forme de « caution humaine ».

Cette supervision n’a pas été pour autant « neutralisé » Grok. xAI – Elon Musk en tête – se vante de lui avoir donné de la personnalité. Il en a effectivement, et elle oscille du sel attique à la vulgarité.

based grok

🥯🥄🚫 pic.twitter.com/PF8n4sGhJZ

— Viv (@battleangelviv) November 5, 2023

#GrokThots https://t.co/6LN44YtS4N pic.twitter.com/9SjMiYstPX

— Christopher Stanley ⛄ (@cstanley) November 5, 2023

Ball so hard… pic.twitter.com/xngpiwW9I2

— Greg Yang (@TheGregYang) November 5, 2023

Sur quoi se fonde Grok ?

Grok repose sur un LLM développé ces quatre derniers mois. Après l'annonce de xAI en juillet, a démarré l'entraînement d'un prototype Grok-0 à 33 milliards de paramètres. Ses capacités, nous affirme-t-on, avoisinaient celles de Llama 2-70B.

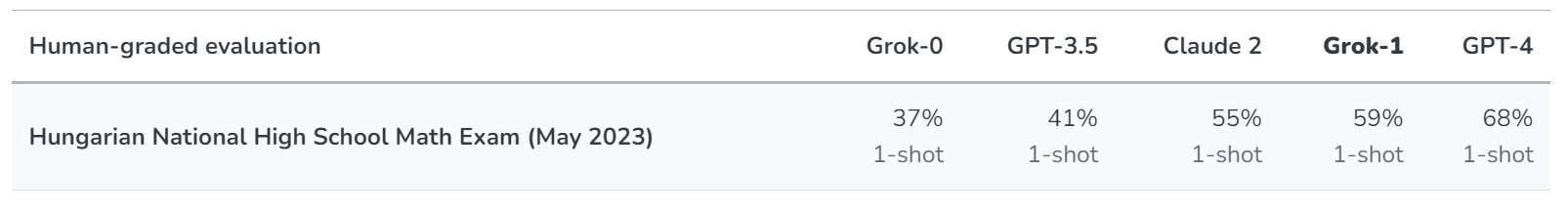

Des améliorations sur le codage et le raisonnement ont mené à Grok-1. xAI l'a comparé à d'autres grands modèles sur quatre benchmarks. En l'occurrence, GMS8k (problèmes mathématiques de niveau collège), MMLU (multiples tâches de traitement du langage), HumanEval (codage) et MATH (problèmes mathématiques de niveau collège et lycée).

Sur la foi de ces tests, Grok est au niveau de GPT-3.5. Voire de Claude 2 sur le traitement du langage et de GPT-4 sur le codage. xAI y ajoute un comparatif « maison » sur la base d'un examen national de maths de niveau secondaire donné en Hongrie. Une forme de confirmation « si jamais [ses] modèles devaient avoir été formés, par inadvertance », sur les quatre benchmarks précédents, disponibles sur le Web.

Pour l'entraînement et l'inférence, xAI a retenu une stack Kubernetes-Rust-JAX (plutôt que PyTorch). Le tout sur « des dizaines de milliers de GPU ».

Que peut faire Grok ?

Officiellement, le champ disciplinaire de Grok couvre la réponse à des questions, la récupération d'informations, l'écriture créative et le codage. Il est capable de chercher sur le Web, mais pas encore par lui-même. X/Twitter est l'une de ses sources (celle « privilégiée », selon Brian Roemmele).

Grok has real-time access to info via the 𝕏 platform, which is a massive advantage over other models.

It’s also based & loves sarcasm. I have no idea who could have guided it this way 🤷♂️ 🤣 pic.twitter.com/e5OwuGvZ3Z

— Elon Musk (@elonmusk) November 4, 2023

La multimodalité est sur la roadmap, aussi bien pour l'audio que pour les images. xAI travaille aussi sur la fenêtre de contexte, actuellement à 8192 tokens.

Grok est multitâche. Illustration ci-dessous, avec le basculement entre deux fenêtres de code et une discussion.

Le chatbot conserve une arborescence des discussions.

Des éditeurs VS Code et Markdown sont intégrés.

Il est possible d'interagir avec Grok en français, mais celui-ci n'a été entraîné qu'en anglais. On ne peut par ailleurs pas encore personnaliser l'interface. Les dossiers de conversations attendront, eux aussi.

A little bit - but it hasn't been specifically trained to support several languages. pic.twitter.com/g1U6Q4GpK1

— Toby Pohlen (@TobyPhln) November 5, 2023

Pour qui et pour quel prix ?

Grok arrive en phase bêta. Celle-ci ne concerne pour le moment que les États-Unis et implique une liste d'attente.

On se dirige vers une disponibilité limitée à l'abonnement X Premium+. Lequel coûte, en France, 16 € par mois ou 168 € par an (TTC). Grok en sera le principal argument de vente. Tout le reste ou presque se trouve dans les forfait inférieurs :

- Basic (3€/mois ou 32 €/an)

Édition des posts, formatage du texte, priorisation dans les fils de réponses, dossiers de signets, tweets marquants, DM chiffrés, création de communautés, etc.

- Premium (8 €/mois ou 84 €/an)

Le socle Basic et, entre autres, moins de publicité, un studio de création graphique, l'accès au badge bleu.

Quant à l'intégration dans les Tesla, cela reste, pour le moment, une simple éventualité...

Deutsche Bank va être super content du logo de Grok. pic.twitter.com/G4bEzn8agS

— Tristan Mendès France (@tristanmf) November 5, 2023

* À consulter en complément, un point sur Dolly et sur StableLM, tous deux entraînés sur The Pile.

Illustration principale © MMollaretti - Adobe Stock