Stable Video Diffusion, le concurrent de Sora, adapté au rendu 3D

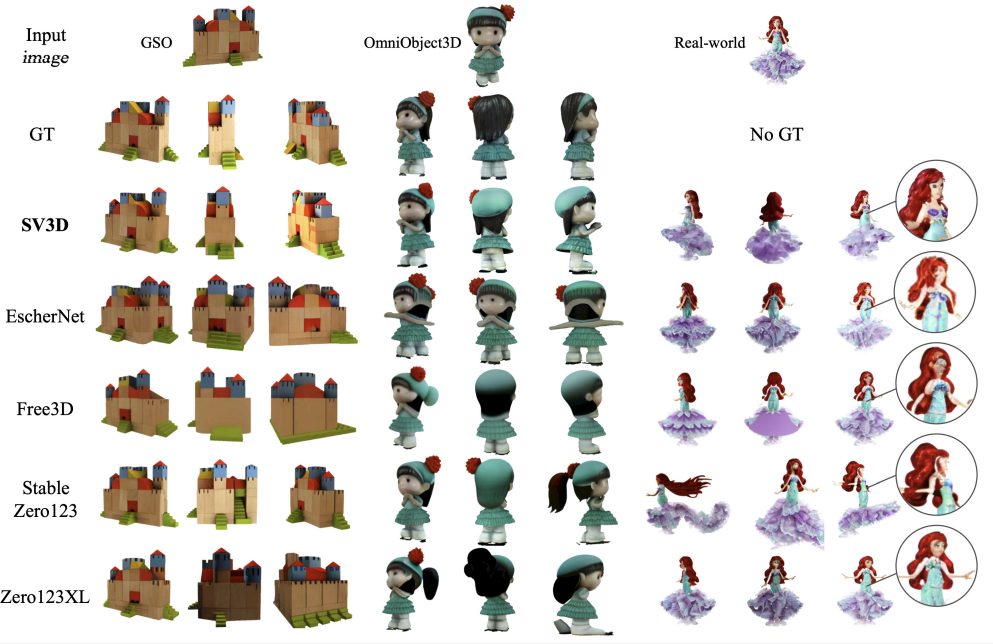

À partir de son modèle image-to-video, Stability AI a conçu un générateur de rendus orbitaux 3D.

Comment créer un modèle générateur d’objets 3D ? Stability AI a exploré plusieurs pistes.

L’entreprise s’est notamment appuyée sur son modèle Stable Diffusion, générateur d’images 2D à partir de texte. Il en a résulté Stable Zero123, publié en décembre.

S’y ajoute désormais Stable Video 3D. Son socle : Stable Video Diffusion. C’est-à-dire un modèle générant des vidéos à partir d’images.

Un générateur 3D basé sur un modèle image-to-video présente plus de capacités de généralisation, constate Stability AI. Autre avantage : la cohérence temporelle en vidéo se traduit par une cohérence spatiale entre vues.

Stable Video 3D : des versions statique et dynamique

Ces vues sont le résultat de la première étape de traitement : Stable Video 3D prend l’image d’entrée et restitue l’objet sous de multiples angles. Les restitutions peuvent être statiques… ou dynamiques, au sens où on fait varier l’élévation et l’azimut. Intervient ensuite la phase de reconstitution 3D (vidéos orbitales). Un procédé proche de la photogrammétrie.

Pour que le modèle maîtrise les variations d’élévation et d’azimut, on l’entraîne en lui communiquant des « trajectoires de caméra » explicites.

Le pipeline de restitution 3D implique, entre autres, l’usage de la fonction SDS assortie de masques et d’optimisations géométriques (symétrie et séparation des échelles).

Stable Video 3D est disponible en deux variantes, qui produisent respectivement des vidéos orbitales statiques et dynamiques. Son usage commercial nécessite une souscription à la licence Stability AI.

Même exigence pour Stable Zero123, dont la version commerciale a la particularité de n’avoir été entraînée que sur des contenus CC-BY et CC0. La version open source a quant à elle été entraînée sur des objets CC-BY-NC.

À consulter en complément :

Modèles text-to-video : qui voisine avec Sora d’OpenAI ?

LLM et smartphones : l’exemple MobileDiffusion

Dix questions avant de choisir de la GenAI « sur étagère »

Illustration principale © Tada Images – Adobe Stock