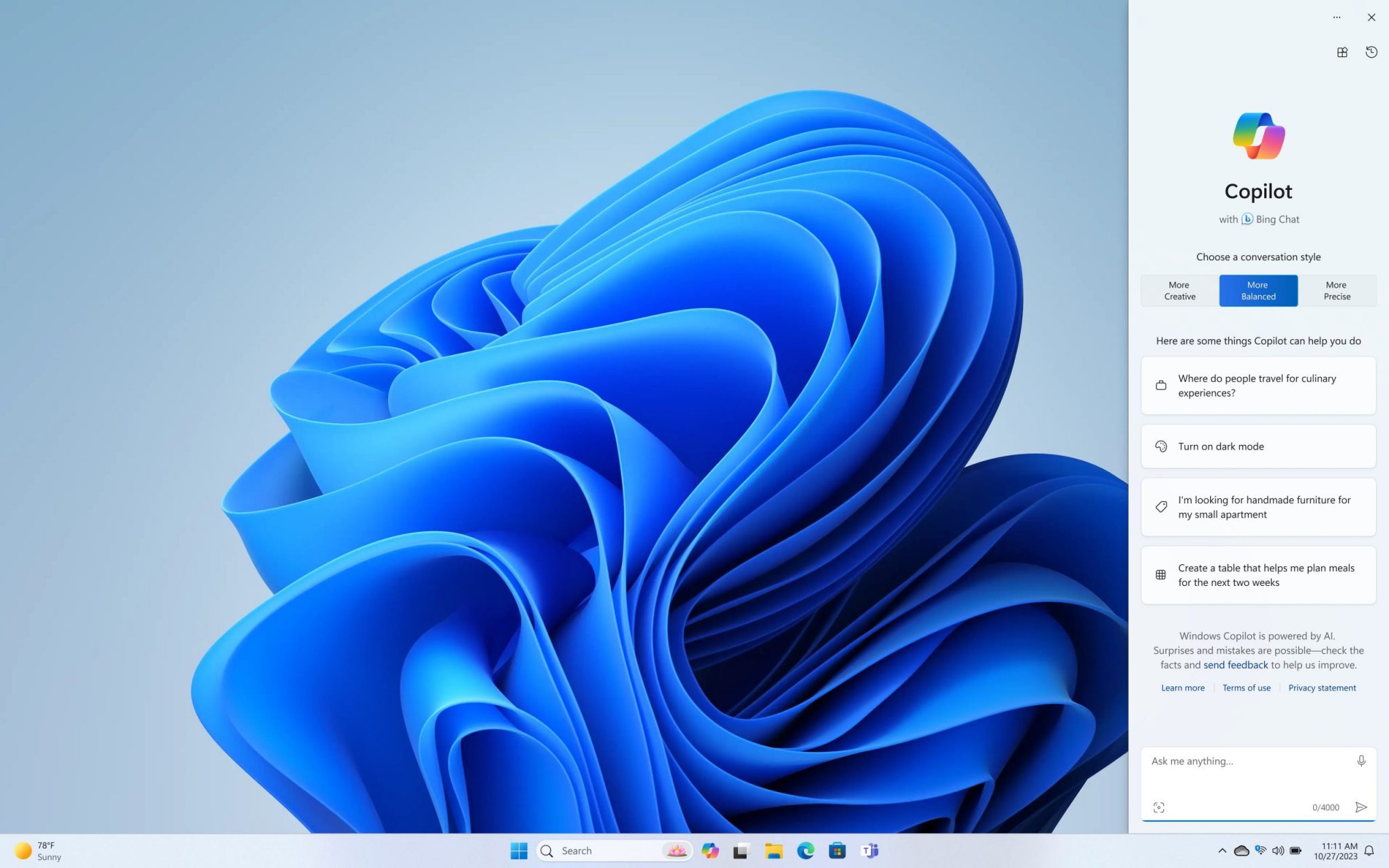

Silicon et KPMG lancent la deuxième édition de l’étude Trends of IT. Cette édition 2024 est co-construite, avec les managers IT de grandes entreprises et d’ETI, pour comprendre les enjeux et partager leurs bonnes pratiques dans l’exécution des projets stratégiques.